Automatisierung am Beispiel autonomes Fahren

Automatisiertes Fahren ist einer der mächtigsten Innovationstreiber in der Automobilindustrie. Im Teil 3 wird der Frage nachgegangen, welche besonderen Anforderungen auf dem Weg zum autonomen Fahren an die Informationsverarbeitung beim Menschen gestellt werden. Die Betonung liegt dabei auf dem Konzept der Situation Awareness (SA), der Situationsbewusstheit, als einem relevanten Sicherheitsfaktor.

Im Teil 1 dieser Reihe „Automatisierung am Beispiel autonomes Fahren“ (Sichere Arbeit 2-2019) wurden die Nachteile technozentrischer Automatisierungsstrategien behandelt und alternative Vorgehensweisen aus psychologischer Sicht beschrieben.

Im Teil 2 (Sichere Arbeit 3-2019) wurde aufgezeigt, dass das Fahren, nicht aber den Zweck des Autofahrens zu beachten zu kurz greift. Die Frage, der in diesem Artikel nachgegangen wurde, ist, verändern sich die Motive, ein Auto zu benützen, wenn es als Fahrgast bestiegen wird und nicht als Fahrerin oder Fahrer?

Die Aufgabe des Autofahrens

Die Aufgabe des Autofahrens macht es für den Menschen erforderlich, zu jedem Zeitpunkt darüber im Bilde zu sein, was gerade passiert, warum es passiert, und eine Vorstellung darüber zu haben, wie sich die Situation weiterentwickeln wird. [1]

Beispiele dafür:

- An einer Kreuzung zu warten und die Geschwindigkeit des überquerenden Fahrzeugs bzw. Verkehrsteilnehmers abzuschätzen, mit dem Ziel, bei angemessenem Abstand in die Straße einzubiegen.

- Den Abstand gemäß den Witterungsbedingungen bzw. Straßenverhältnissen anzupassen.

- Das Verhalten von Fußgängern oder Radfahrern zu checken, um das eigene Fahrverhalten darauf anzupassen.

- Ein Signal wahrzunehmen, zu verstehen und in Folge das Fahrverhalten anzupassen.

- Die technischen Voraussetzungen des Autos korrekt wahrzunehmen, deren Bedeutung zu verstehen und für das eigene Handeln umzusetzen.

- Die Geschwindigkeit anzupassen, wenn man in eine Kurve fährt.

Die Geschwindigkeit zu regeln ist eine Aufgabe, die aktiv auszuführen ist, da sie dynamisch abläuft. In diesem Fall bedeutet dynamisch, dass dabei veränderliche Vorgabegrößen kontinuierlich zu beachten sind. [vgl. 2; S. 11]

Um eine Kollision zu vermeiden, muss ein Autofahrer also ständig das eigene Verhalten rechtzeitig den Umgebungsbedingungen anpassen. In anderen Worten: Er muss sie vorhersehen können. Die Autofahrerin, der Autofahrer steht in Wechselbeziehung zwischen Verkehrsteilnehmerinnen und -teilnehmern, der Situation und der Technik. Situationsaspekte können aus der Verkehrssituation oder den Umgebungs- und Wetterbedingungen kommen.

Die Wahrnehmung der Umgebungsbedingungen, das Verständnis ihrer Bedeutung und das Abschätzen in die Zukunft schaffen „Situationsbewusstheit“. Das von Endsley (1995) formulierte Konzept der „Situation Awareness“ (SA) betont die vorausschauende, antizipative Komponente und deren Bedeutung in sicherheitskritischen Situationen, z. B. in Risikotechnologien. [3].

Was unterscheidet gute und noch bessere Autofahrerinnen und Autofahrer?

Autofahrerinnen und Autofahrer unterscheiden sich in ihrer vorausschauenden Fahrweise. Merkmale für situationsbewusstes Fahren sind: ([1] Tab. 1; [4] S. 290; [3] S. 255)

Merkmale für gegebene Situationsbewusstheit

- Kennen und Erfahren auch von Vorzeichen (Vorsignalen) für handlungsrelevante Situationen

- Zutreffende Voraussagen

- Organisieren zeitlicher Voraussetzungen künftiger Anforderungsbewältigung

- Organisieren sachlicher Voraussetzungen künftiger Anforderungsbewältigung (Vorausplanen)

- Zeitgerechtes Entscheiden

- Überzeugung der Beherrschung der Situation/Ablauf

Merkmale beeinträchtigter Situationsbewusstheit

- Wenig/kein Erfassen für Entwicklungen

- Wiederholtes Einholen identischer Informationen

- Wenig organisiertes und vorausschauendes Handeln

- Überrascht werden von Handlungserfordernissen

- Erleben des Getriebenseins durch Ereignisse

Die Wahrnehmung der Umgebungsbedingungen, das Verständnis ihrer Bedeutung und das Abschätzen in die Zukunft schaffen Wissen.

Wissen, das im besonderen Maße Spezialistinnen und Spezialisten bzw. „Spitzenkönner“ haben, wie die Forschung zeigt. Das im SA- Konzept beschriebene proaktive Vorgehen auf der Suche nach Erfahrungsgewinn, z. B. über Vorzeichen für sich anbahnende Zustände, wird von Spezialistinnen und Spezialisten genutzt, um „Critical Incidents“ vorbeugend zu vermeiden. [4; S. 290–291]

Wissen, das für die Programmierung des Computersystems zum autonomen Fahren von entscheidender Bedeutung für die Sicherheit ist. Wissen, das mit ansteigendem Automatisierungsgrad beim Menschen verloren geht.

Gleichzeitig muss das Wissen über die Systemtechnik bzw. deren Software zunehmen, um den Aufbau eines mentalen Modells beim Menschen zu gewährleisten. Der Mensch muss sich ein Bild machen können, wie das System funktioniert. Abbilder sind die „Datenbasis“ der zu bedenkenden Realität. Andernfalls besteht bei zunehmender Automatisierung die Gefahr, dass es zu Abweichungen kommt. Abweichungen zwischen dem mentalen Modell des Autofahrers über sein Auto einerseits und dem Zustand bzw. Verhalten des Fahrzeuges andererseits. Die technischen Voraussetzungen des Autos korrekt wahrzunehmen, deren Bedeutung zu verstehen und für das eigene Handeln umzusetzen, das gilt auch für die Zwischenstufen auf dem Weg zum autonomen Fahren als ein Sicherheitsfaktor. Die Praxis zeigt, dass Simulationstrainings vor allem dort eingesetzt werden, wo ein passendes mentales Modell über Prozesse und Verhalten des Systems ausgebildet werden soll. [5; S. 44]

Überspitzt formuliert könnte man sagen, Erfahrungen bzw. Wissen über die reale Welt wird abgebaut, Wissen um die virtuelle Welt muss aufgebaut werden.

Der Mensch spielt eine aktive Rolle im technischen System

Die Forschung geht heute von einer aktiven Rolle des Menschen im technischen System aus. Das gilt für die Informationsverarbeitung ebenso wie für das Konzept der SA. Mit der Annahme, dass der Mensch eine aktive Rolle im technischen System übernimmt, verändert sich auch die Auffassung der Aufgabe des Autofahrens als eine hoch dynamische und (mit der Technik) interaktive Aufgabe, die der Mensch zu erfüllen hat.

Als Beispiel nennt Sträter ein Überholmanöver. Das macht es erforderlich, die Geschwindigkeit des rückwärtigen Verkehrs abzuschätzen, zum Überholen anzusetzen und wieder zu kontrollieren, ob sich die Situation auf der linken Spur gemäß seiner Einschätzung entwickelt hat. [1] Es bedarf daher sowohl beim Programmieren von Fahrassistenten als auch bei der Betrachtung der Anforderungen an den Menschen beim Autofahren einer ganzheitlichen Sichtweise auf die Situation. In der kognitiven Psychologie ging man zunächst von einem Informationsverarbeitungsansatz aus, der eine sequenzielle Informationsverarbeitung annimmt. Der Mensch nimmt Informationen wahr, verarbeitet sie und handelt entsprechend der wahrgenommenen Situation. In technik-orientierten Verfahren zur Beurteilung menschlicher Fehler ging und geht man auch heute noch fallweise von diesem Ansatz aus.

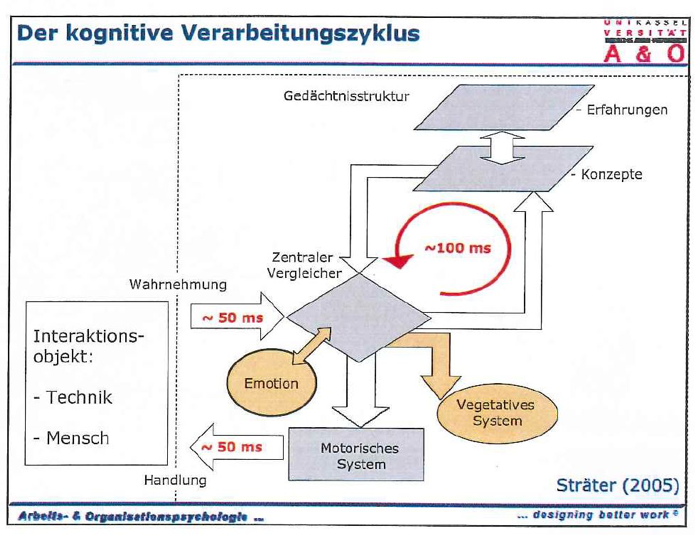

In der Weiterentwicklung des Ansatzes zur Informationsverarbeitung kam es zu einer Erweiterung auf das System, in dem sich der Mensch befindet. Der Mensch wird als Teil des soziotechnischen Systems und als ständiger „Informationsverarbeiter“ aufgefasst. Der Mensch interagiert mit dem technischen Umfeld sowohl passiv als auch aktiv über ein und denselben konsistenten Verarbeitungszyklus (Abbildung 1) [6]. Dabei werden die Innenwelt und die Außenwelt ständig miteinander abgeglichen. Die kognitive Psychologie, insbesondere die Psychomotorik-Forschung, hat zum Verständnis, wie der Mensch und ein System oder auch der Mensch und andere Menschen wechselweise aufeinander einwirken, wesentlich beigetragen. [7].

Heute erklärt man die Unzuverlässigkeit von Systemen auch als eine Form der fehlerhaften Passung zwischen den Anforderungen des technischen Systems und den Handlungsmöglichkeiten der Menschen.

Ursachen für die Unzuverlässigkeit von Systemen:

- Grenzen menschlicher Wahrnehmung, Aufmerksamkeit, Gedächtnis, Verarbeitung oder Prognose werden missachtet.

- Die Systemkomplexität verunmöglicht, Störungen vorherzusehen, zu beeinflussen oder zu durchschauen.

Hohe Systemkomplexität ist besonders dann von Nachteil, wenn bei Erreichen der Systemgrenzen der Mensch zur Übernahme aufgefordert wird – das ist beispielsweise beim automatisierten Fahren in Stufe 3 in Abbildung 1 [8; S. 31] der Fall. Generell sinken bei technozentrischer Automatisierungsstrategie mit steigendem Automatisierungsgrad die Handlungsmöglichkeiten des Menschen.

Wie zuverlässig ist der Mensch?

Mit der Annahme, dass der Mensch eine aktive Rolle im technischen System übernimmt, ändern sich auch die Grundlagen zur mathematischen Modellierung von Mensch-Maschine-Systemen (MMS). Als Mensch-Maschine-System wird das Gesamtsystem von Mensch, Schnittstelle und dahinterliegendem technischem System bezeichnet. Um die Zuverlässigkeit der Systemvoraussetzungen zu prüfen bzw. vorhersagen zu können, sind alle Systemkomponenten einzubeziehen, auch die Systemkomponente Mensch. Das erfordert die Überführung von menschlichen Informationsverarbeitungsprozessen in mathematische und damit berechenbare Ausdrücke, „kognitive Modellierung“ genannt. Dabei wird angenommen, dass es bei zu lösenden Aufgaben ein Kriterium der Richtigkeit der Lösung („im Akzeptanzbereich“) gibt und sich die „Fehlerwahrscheinlichkeit“ wie die „Ausfallswahrscheinlichkeit“ einer Maschinenkomponente berechnen lässt. [9]

Beispiel: Definition menschlicher Zuverlässigkeit nach VDI 4006-1: [10; S. 5]

„Die menschliche Zuverlässigkeit ist die Fähigkeit des Menschen, eine Aufgabe unter vorgegebenen Bedingungen für ein gegebenes Zeitintervall im Akzeptanzbereich durchzuführen.“

Bedenken bezüglich der Berechenbarkeit der menschlichen Zuverlässigkeit kommen aus der Praxis, vom internationalen Fachverband der Strom- und Wärmeerzeuger, einem freiwilligen Zusammenschluss von Unternehmen der Kraftwerksbetreiber und -hersteller. [11]

„Der Mensch zeichnet sich durch eine wesentlich größere Variabilität und Komplexität im Vergleich zum technischen System aus. Die Berücksichtigung des Verhaltens des Menschen ist eine der Hauptquellen für Unsicherheiten in Risikoanalysen.“

Zudem zeigt sich, dass die beteiligten Disziplinen (Psychologie, Ingenieurswissenschaften und Informatik) ein sehr unterschiedliches Verständnis von kognitiver Modellierung haben.

Einwände bezüglich der Berechenbarkeit menschlicher Zuverlässigkeit kommen auch aus der Psychologie. Hans Peter Musahl kritisiert, dass die MMS-Modellierung von falschen Modellannahmen ausgeht, da für keine der drei Komponenten Technik, Organisation/Situation und Person angenommen werden darf, dass aus dem bestimmungsgemäßen Funktionieren zum Zeitpunkt t1 eine sichere Annahme über ihr Funktionieren zum Zeitpunkt t2 abgeleitet werden kann. Mit einer vierten Komponente „Zeit“ müssten die systematischen Veränderungen in der Zeit modelliert werden können.

Ebenso wird die (mathematische) Vernachlässigung oder das Fehlen der systemischen Wechselwirkungen kritisiert. Geht man von einer gegenseitigen Abhängigkeit von Mensch, Technik und Organisation bzw. Situation aus, sind die Systemkomponenten Mensch, Technik und Organisation nur in ihrem Zusammenwirken verstehbar. Jede Änderung einer der Komponenten verändert das gesamte System. Damit sollte das spezifische Systemverhalten als eine Wechselwirkung dritter Ordnung aufzufassen sein. [12; S. 2]

Oliver Sträter schlägt vor, das Konzept SA in die Systemgestaltung von MMS einzubeziehen. [1] Mit der Annahme von SA als eigenständiges Konzept ändern sich auch die Grundlagen zur mathematischen Modellierung von Mensch-Maschine-Systemen (MMS). Er unterscheidet zunächst die Ebene der Situation, die Ebene des Wahrnehmens und Handelns und die Ebene der Bildung von Situationsbewusstheit und beschreibt eine Herangehensweise, die eine Operationalisierung eines Gesamtkonzepts möglich macht. Verschiedene Voraussetzungen sind daran geknüpft. So macht ein Konzept für die Systemgestaltung unter Berücksichtigung des SA-Konzepts einen soliden Ansatz zur Messung von SA erforderlich. In den letzten Jahren wurden dazu Methoden zur Messung des Situationsbewusstseins entwickelt. Die bekanntesten sind: (vgl. [1] Tabelle 2, S. 49)

- SAGAT: Situation Awareness Global – Assessment Technique

- SART: Situation Awareness Rating Technique

- SPAM: Situation Present Assessment Method

- SAVANT: Situation Awareness Verification Analysis Tool

- SALSA: Situation Awareness bei Lotsen der Streckenflugkontrolle im Kontext von Automatisierung

- SAPS: Situation Awareness ProbeS

- C-SAS: Cranfield Situation Awareness Scale

- SALIANT: Situation Awareness Linked Indicators Adapted to Novel Tasks

u.s.w.

WIE werden wir beim Autofahren gefordert?

In der Prävention ist es geübte Praxis, sich Gefahren immer und immer wieder bewusst zu machen. Das dient einerseits dem Aufbau von Wissen über Gefahren, andererseits soll es dazu führen, dass gefährliche Tätigkeiten mit größerer Aufmerksamkeit durchgeführt werden. Aus der Aufmerksamkeitsforschung weiß man, dass Fehler eher passieren, wenn man unkonzentriert ist. Aus einer ganzheitlichen Sicht ist damit die Frage nach dem „Warum?“ jedoch noch nicht gelöst, weil die Fehlhandlungsbedingungen unabhängig von der Person (weiter) existieren. [13]

Fahraufgaben erfordern unterschiedliche Grade der Aufmerksamkeit. Die Veränderung der Aufmerksamkeitsverteilung über das gesamte Geschehen mit zunehmendem Automatisierungsgrad ist für die Sicherheit von Bedeutung. Vereinfachend kann man sagen, dass der Grad der erforderlichen Aufmerksamkeit und Konzentration die Bewusstseinsebenen beschreibt.

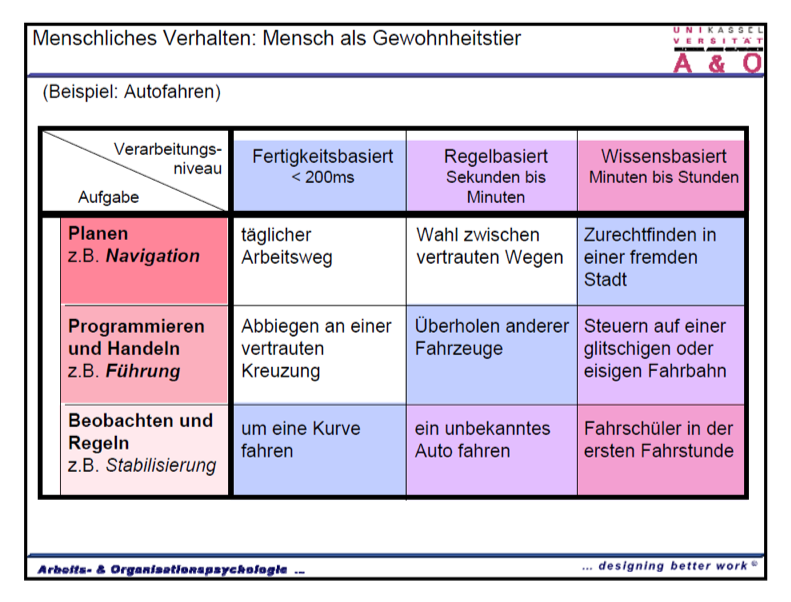

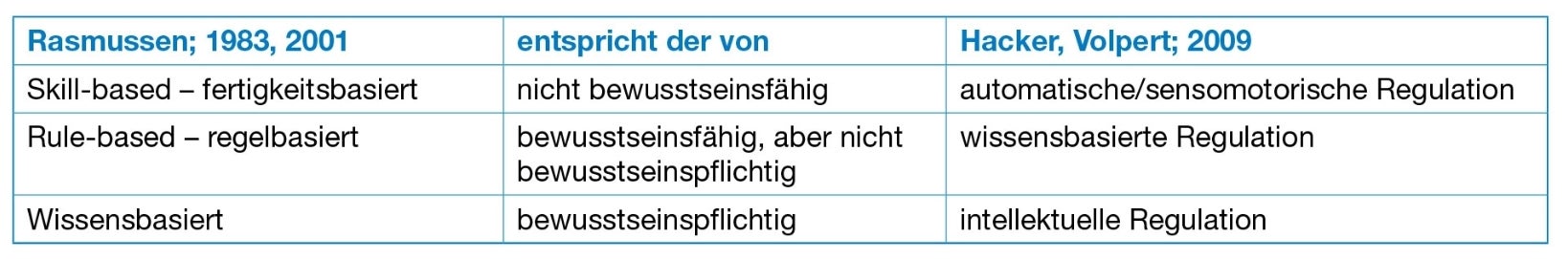

Die durch deren Bewusstseinsebenen unterscheidbaren Niveaus der psychischen Regulation haben allgemeinpsychologische Gültigkeit. In Tabelle 1 sind drei unterschiedliche Ebenen der Informationsverarbeitung beschrieben. Je nach dahinterliegendem Modell werden sie verschieden bezeichnet: gemäß dem Leitermodell der Informationsverarbeitung von Rasmussen und Reason [5] einerseits und den Ebenen bzw. Modi der psychischen Tätigkeitsregulation nach Hacker [14; S. 41] andererseits.

Auf die Frage „WIE werden wir beim Autofahren gefordert?“ ist die Antwort demnach „unterschiedlich“. Das Autofahren enthält einfache Operationen (Bewegungskomplexe), die sich fortwährend wiederholen und daher keine Aufmerksamkeit benötigen. Dass sie überwiegend automatisch erfolgen, ist dem Umstand zu verdanken, dass „schweigendes Wissen“ wirksam ist. Das Autofahren enthält aber auch Operationen, die immer wieder gleich ablaufen, aber Konzentration erfordern. Dabei spielt Übung und Erfahrung eine Rolle. Immer dann, wenn beim Autofahren etwas Unerwartetes und/oder etwas Schwieriges passiert, löst das bewusst gesteuertes Nachdenken und Emotionen auf einem höheren Verarbeitungsniveau aus. Daraus folgt, dass Vielfalt und Höhe der geistigen Anforderungen je nach Situation im Straßenverkehr variieren, wie Abbildung 2 zeigt – hier gemäß dem Leitermodell nach der Klassifikation nach Rasmussen und Reason. [5] Deutlich erkennbar ist, dass mit der Komplexität des Verarbeitungsniveaus auch die Verarbeitungsdauer ansteigt.

Da am Weg zum autonomen Fahren zunehmend die Steueraufgaben von automatisiert arbeitenden Computersystemen übernommen werden, sind die verbleibenden Aufgaben beim Menschen folglich Überwachungs- und Kontrolltätigkeiten, die durch visuelle Informationsaufnahme und -verarbeitung sowie die Koordination von Aufgaben gekennzeichnet sind. Bei reiner Überwachungstätigkeit ist davon auszugehen, dass kein System- und Bedienungswissen erforderlich ist.

Es ist anzunehmen, dass der Anteil bewusstseinsfähigen, aber nicht bewusstseinspflichtigen intuitiven Denkens des „schnellen System 1“ mangels Erfahrung und Wissen abnehmen wird. Es muss durch ein zunehmendes Wissen über den Umgang mit dem System abgelöst werden. Das für SA typische „Kennen und Erfahren von Vorzeichen (Vorsignalen) für handlungsrelevante Situationen“ muss paradoxerweise das automatisiert arbeitende Computersystem übernehmen.

Die Unzuverlässigkeit technischer Systeme lassen sich mit zunehmendem Automatisierungsgrad neben der „fehlerhaften Passung“ auch mit den „Ironien der Automatisierung“ nach Bainbridge erklären: [3; S. 110]

- Systementwickler versuchen den Menschen als (unberechenbaren) unzuverlässigen Systemteil aus dem Prozess herauszuhalten. In Not- und Sonderfällen sollen jedoch die vermeintlich unzuverlässigen Menschen die Verantwortung über das angeblich so zuverlässige System übernehmen. Was dabei fehlt, sind oftmals Erfahrungswissen und Vorkenntnisse, Aufmerksamkeit oder Konzentration, die Kenntnis der Entstehungsgeschichte eines Störzustandes oder Erfahrung im Umgang mit plötzlich entstehende Ausnahmesituationen.

- Die Systementwickler selbst sind Menschen, die Fehler machen und entsprechend fehlerhafte Systeme entwickeln können. Nicht nur der Bediener/User, sondern auch der Konstrukteur oder Programmierer stellen ein Sicherheitsrisiko dar.

- Nach Hacker und Sachse könnte man, übertragen auf das autonome Fahren, eine dritte „Ironie“ ergänzen. Beim hochautomatisierten Autofahren werden die in der Tätigkeit „Autofahren“ enthaltenen Motivierungsangebote für ein konzentriertes intensives Fahren wegautomatisiert. Gerade aber bei meist auch kostspieligen hochautomatisierten Systemen wird ein hochmotiviertes Überwachen erwartet. [3; S.111] Der Teil 2 dieser Reihe „Automatisierung“ am Beispiel „autonomes Fahren“ widmete sich dem Thema Motivation. [15]

Das Problem der Unzuverlässigkeit technischer Systeme bzw. Anlagen erfordert ein Abwägen des Gefährdungspotentials. Die Erfahrung zeigt, dass das Gefährdungspotenzial nicht so sehr darin besteht, dass es zu Störungen und Abweichungen kommt, sondern in den schwerwiegenden, weitreichenden und oftmals unvorhersehbaren Folgen der Abweichung. Es gilt daher, das Gefährdungspotenzial automatisierten Fahrens und seiner Zwischenstufen abzuwägen.

Fazit

Automatisierung kann den Menschen entlasten und beim Denken und Handeln unterstützen. Voraussetzung dafür ist, das „Psychische“ an der Tätigkeit, z. B. beim Autofahren, zu beachten. Das beginnt bereits bei der Wahl der Automatisierungsstrategie, wie im Teil 1 ausgeführt wurde. [7] Eine weitere Voraussetzung ist es, nicht nur das Fahren, sondern auch den Zweck des Autofahrens zu beachten, wie im Teil 2 ausgeführt wurde. [16]

Im vorliegenden Teil 3 wurde gezeigt, dass nur die beobachtbaren Ausführungsschritte beim Fahren als Grundlage für die Systementwicklung zu betrachten, ein Versäumnis darstellt. Heute wissen wir viel über die Informationsverarbeitung beim Menschen, wie er fortlaufend wechselnde Signale von außen aufnimmt, verarbeitet und Maßnahmen setzt. Am Weg zum automatisierten Fahren besteht die Gefahr, das dazu benötigte Wissen zu verlernen. Besonders für das vorausschauende Denken und die Vorstellung darüber, wie sich die Situation weiterentwickeln wird, ist Situationsbewusstheit erforderlich. SA kann sich jedoch nur durch Erfahrung, Wissen und Umgang mit vielfältigen Situationen entwickeln. Aus ganzheitlicher Sicht ist es auch hier notwendig, die übergeordnete Handlungsebene in der Systementwicklung zu berücksichtigen. Nicht nur die Bestandteile des Autofahrens, sondern das Ziel einer Autofahrt, deren Strukturierung und Planung sollte der Ausgangspunkt einer angemessenen Analyse sein, wie es Hacker für Arbeitsbewegungen nachvollziehbar ausgeführt hat. [17]

Fazit ist wie auch schon im Teil 1 und 2: Will man Fehlentwicklungen in der Automatisierung vermeiden, ist es notwendig,

- dass die beteiligten Disziplinen Psychologie, Ingenieurswissenschaften und Informatik ein gemeinsames Verständnis entwickeln.

- in der Systementwicklung bedienerbezogene Gestaltungsziele klar als eigenes Gestaltungsziel zu definieren, wie das im dualen Entwurfsprozess der Fall ist.

Mensch, Technik und Situation sind aufgrund ihrer gegenseitigen Abhängigkeit nur in ihrem Zusammenwirken zu verstehen. Das ist in der Systementwicklung zu berücksichtigen.

Im Teil 4 dieser Reihe zum Thema Automatisierung werden Fehler und Fehlerklassifikationen sowie Voraussetzungen für die Fehlervermeidung ausgeführt.

LITERATUR

- [1] Sträter, Oliver (2009). Cognitive Parameter for the Relationship of Situation Awareness and Behaviour. Zeitschrift für Arbeitswissenschaft, 63 (1), 45–54.

- [2] Lindner, T., Milius, B., Arenius, M., Schwencke, D., Grippenkoven, J., Sträter, O. Betrachtung zur Zuverlässigkeit des Triebfahrzeugführers. Erfassung sicherheitsbeeinflussender Faktoren und ihrer Bedeutung auf Basis von Ereignisdaten. EI-Eisenbahningenieur. Jänner 2014.

- [3] Hacker, W. & Sachse, P. (2014). Wissensbasierte Regulation von (Arbeits-)Tätigkeiten. S. 255–293. In: Allgemeine Arbeitspsychologie (3. vollständig überarbeitete und ergänzte Auflage). Bern: Verlag Hans Huber.

- [4] Hacker, W. (2009). Arbeitsgegenstand Mensch. Psychologie dialogischer-interaktiver Erwerbstätigkeit. Lengerich: Pabst Verlag.

- [5] Kluwe, R., H. (2006). Informationsaufnahme und Informationsverarbeitung. In: Konradt, Udo; Zimlong, Bernhard und deutsche Gesellschaft für Psychologie (Hrsg.) Ingenieurspsychologie. Hogrefe Verlag.

- [6] Sträter, O. Unfallanalyse, Sicherheit, mentale Belastung. Seminarunterlagen AK Wien. September 2010.

- [7] Sträter, O. (2005). The Cognition Processing Loop. In: Cognition and Safety. An Integrated Approach to Systems Design and Assessment; S. 61–80. Ashgate Publishing Company.

- [8] Rothmeier-Kubinecz, S. (2019). „Automatisierung am Beispiel autonomes Fahren“. Teil 1: Automatisierungsstrategien. Sichere Arbeit, Heft 2. Wien: S 27–33. Wien: Medieninhaber AUVA.

- [9] Verein Deutscher Ingenieure VDI-Richtlinie 4006 Blatt 2 (2017). Menschliche Zuverlässigkeit. Methoden zur quantitativen Bewertung menschlicher Zuverlässigkeit.

- [10] Verein Deutscher Ingenieure VDI-Richtlinie 4006 Blatt 1 (2015). Menschliche Zuverlässigkeit. Ergonomische Forderungen und Methoden der Bewertung.

- [11] VGB powertech – Fachverband der Strom- und Wärmeerzeuger (2009). Konzept für die Bewertung menschlicher Fehlhandlungen in technischen Systemen.

- [12] Musahl, H.-P. (2007). Fehlerfreundlichkeit. Kognitionspsychologische Herausforderungen eines komplexen Störungsmanagements in Mensch-Maschine-Systemen. VDI Wissenforum (Hrsg). Instandhaltung auf dem Prüfstand. Tagung, Stuttgart, 19.–20.6.2007 (S. 1–19). VDI-Berichte Nr. 1991. Düsseldorf: VDI-Verlag. Downloadmöglichkeit: http://www.aowpsychologie.com/.911_Analyse.1001,528-----------,,2.html

- [13] Wehner, T., Stadler, M. (1994). Arbeitssicherheit und Fehlerfreundlichkeit – ein Gegensatz? Konzeption und empirische Befunde zur psychologischen Fehlerforschung. In N. Beckenbach & W. van Treek (Hrsg.). Umbrüche gesellschaftlicher Arbeit. Soziale Welt. Sonderband 9. 409–428.

- [14] Hacker, W. (2015). Psychische Regulation von Arbeitstätigkeiten. Kröning: Asanger Verlag GmbH.

- [15] Rothmeier-Kubinecz, S. (2017). Computer says no. Wissensarbeit im digitalen Zeitalter. (Teil 1). Sichere Arbeit, Heft 2 Wien; S.28–33. Wien: Medieninhaber AUVA

- [16] Rothmeier-Kubinecz, S. (2019). „Automatisierung am Beispiel autonomes Fahren“. Teil 2: Motivation. Sichere Arbeit, Heft 3. Wien: S 42–46. Wien: Medieninhaber AUVA

- [17] Hacker, W. (2005). Sensomotorische Ausführungsregulation von Arbeitstätigkeiten. In: Allgemeine Arbeitspsychologie. 2., vollständig überarbeitete und ergänzte Auflage. S. 602–668. Hans Huber: Bern

Zusammenfassung

Will man Fehlentwicklungen in der Automatisierung vermeiden, ist es notwendig, dass die beteiligten Disziplinen Psychologie, Ingenieurswissenschaften und Informatik ein gemeinsames Verständnis entwickeln und in der Systementwicklung bedienerbezogene Gestaltungsziele als eigenes Gestaltungsziel zu definieren, wie das im dualen Entwurfsprozess der Fall ist. Mensch, Technik und Situation sind aufgrund ihrer gegenseitigen Abhängigkeit nur in ihrem Zusammenwirken zu verstehen. Das ist in der Systementwicklung zu berücksichtigen.