Evaluation

Evaluation komplexer Maßnahmen in einer komplexen Arbeitswelt

Im Frühjahr 2018 fand das 5. Fachgespräch Evaluation mit dem Titel „Evaluation komplexer Maßnahmen in einer komplexen Arbeitswelt – Wie kann das gelingen?“ in Dresden statt. Das Fachgespräch Evaluation ist eine Veranstaltung des Sachgebiets „Evaluation“ der Deutschen Gesetzlichen Unfallversicherung (DGUV). Es findet alle zwei Jahre in Kooperation mit dem Institut für Arbeit und Gesundheit (IAG) statt. Die AUVA war mit einer Posterpräsentation und einem Vortrag bei der Veranstaltung vertreten.

Aus dem lateinischen „valere“ (stark, wert sein) hergeleitet, bedeutet Evaluation sach- und fachgerechte Bewertung. Voraussetzung dafür ist ein spezifisches Denkmodell, das ein nachprüfbares Verfahren des Bewertens von Sachverhalten, Prozessen, Gegenständen oder Organisationseinheiten beinhaltet. In Hinblick auf den Evaluationsprozess kann Evaluation als „jede methodisch kontrollierte, verwertungs- und bewertungsorientierte Form des Sammelns, Auswertens und Verwertens von Informationen“ beschrieben werden (Kromrey 2001, S. 105). Evaluation bezeichnet aber auch das Ergebnis des Evaluationsprozesses und dessen Dokumentation in einem Evaluationsbericht.

„Komplexität“ war der diesjährige Schwerpunkt des Fachgesprächs Evaluation. Oftmals geht es bei Evaluationsaufträgen in der gesetzlichen Unfallversicherung darum, komplexe Maßnahmen bzw. Interventionen zu evaluieren. Der Begriff Komplexität begegnet uns nahezu alltäglich. In den Medien, aber auch in Diskussionen, geht es vielfach um komplexe Anforderungen und um die Reduzierung der Komplexität von Problemlagen. Bei komplexen Systemen sind zahlreiche Systemelemente stark miteinander verknüpft, sie werden darüber hinaus noch von Geschehnissen der Umwelt beeinflusst, entwickeln sich ständig weiter oder verändern sich.

Inhalt und Ablauf

Der Fokus des 5. Fachgesprächs Evaluation richtete sich auf die folgenden Fragestellungen:

- Was genau macht Komplexität aus bzw. warum wird ein Sachverhalt als komplex bezeichnet?

- Wie und mit welchen Methoden können wir bei Evaluationen den verschiedenen Komplexitätsdimensionen gerecht werden?

Mögliche Antworten wurden zunächst auf allgemeiner Ebene als Themenaufriss präsentiert. Danach wurden Beispiele komplexer Evaluationsvorhaben vorgestellt und das methodische Vorgehen bei der Evaluation sowie die Bewältigung der Komplexität diskutiert. Auf „Marktplätzen der Evaluationen“ gab es zudem die Möglichkeit, einzelne Evaluationsbeispiele in Form von Posterpräsentationen kennenzulernen und sich in Kleingruppen dazu auszutauschen.

Komplexität und Wirkung

Im Eröffnungsvortrag widmete sich Prof. Dr. Rüdiger von der Weth (Hochschule für Technik und Wirtschaft, Dresden) allgemeinen Fragen des Phänomens „Komplexität“. Dimensionen und Betrachtungsebenen von Komplexität wurden dabei ebenso erläutert wie Verhaltenskonsequenzen und Risiken. Abschließend wurden methodische Herausforderungen für die Evaluation komplexer Systeme diskutiert. Ursprünge der Beschäftigung mit praktischen Komplexitätsproblemen aus sozialwissenschaftlicher Sicht liegen in der Stadtplanung. Bekanntes Beispiel ist die Studie zur „Stadtplanung in Lohhausen an der Lohe“ (vgl. Dörner et al. 1983). Hier handelt es sich um ein komplexes Problem, weil sich das System der Stadt aus vielen verschiedenen Einflussvariablen zusammensetzt, welche die Verarbeitungskapazität des „Problemlösenden“ überschreiten und zur Informationsreduktion zwingen. Zudem sind die Variablen untereinander stark vernetzt, wechselseitige Abhängigkeiten müssen berücksichtigt werden. Die Eigendynamik des Systems führt zu kaum vorhersehbaren Entwicklungen. Durch Intransparenz im System stehen notwendige Entscheidungsgrundlagen nur teilweise zur Verfügung. Die sogenannte Polytelie bezeichnet die Anforderung, nicht nur ein Kriterium zu optimieren, sondern viele zum Teil widersprechende Bedingungen zu beachten.

Merkmale, die solche komplexen Problemstellungen beeinflussen können, lassen sich nach Joachim Funke (2006) in die drei Bereiche Personenmerkmale, Situationsmerkmale und Systemmerkmale einteilen. Die Vielfältigkeit komplexer Systeme macht es nicht nur schwer, alle relevanten Aspekte und deren Wechselwirkungen ausreichend in der Gestaltung und Maßnahmenplanung zu berücksichtigen, sondern stellt darüber hinaus auch die Evaluation vor das Problem, den „Erfolg“ solcher Maßnahmen zu bewerten.

Fehler bei der Gestaltung komplexer Systeme sind laut Dörner (1989) nicht allein auf kognitive Fähigkeiten oder Motivation rückführbar. Vielmehr stünden sie in Zusammenhang mit Kontrolle und Selbstwirksamkeit, so Rüdiger von der Weth. Solange Menschen glauben, viel Kontrolle über eine Situation auszuüben, empfinden sie sich als selbstwirksam. Da Menschen nach Kontrolle und Selbstwirksamkeit streben, kann Kontrollverlust zu unangemessenen Vermeidungsstrategien führen, die sich zum Beispiel folgenden Phänomenen zuordnen lassen:

- Einkapselung: Man konzentriert sich auf ein eingeschränktes Teilgebiet seiner Arbeit, das man möglichst gut beherrscht, und steigert so das Kontrollempfinden.

- Mangelnde Zielkonkretisierung: Man untersucht nicht, was gewählte Ziele in der praktischen Konsequenz bedeuten, weil dadurch möglicherweise Widersprüchlichkeiten deutlich werden könnten.

- Ballistisches Handeln: Man betreibt ein sinnloses Projekt mit aller Macht und gegen alle Widerstände weiter, weil ein Eingestehen des Misserfolges das Kontrollempfinden senken würde.

Auch dort muss die Evaluation komplexer Projekte ihren Blick hinrichten, um im Rahmen der formativen Evaluation etwaige Fehlentwicklungen rechtzeitig zu erkennen und dem Projektteam rückzuspiegeln. Methodische Herausforderung für die Evaluation komplexer langfristiger Projekte ist die begleitende Modellierung der zu untersuchenden Prozesse, die laufend weiterentwickelt werden muss. Daher ist laut von der Weth Flexibilität in der Evaluation erforderlich: „Man weiß nicht von Anfang an, was wichtig ist, und muss alles betrachten, was irgendwie wichtig werden könnte. Man kann sich nicht sicher sein, welche Daten bis zum Schluss erhoben werden können. Man muss möglicherweise im Laufe der Zeit auch die Datenerhebung verändern.“ Die auf dieser Basis erhobenen Daten müssen in das Modell einfließen, zu einem Modell zusammengeführt werden. Von der Weth beendete seinen Vortrag mit dem praktischen Beispiel einer Methode zur Modellierung komplexer Softwareeinführungsprojekte.

Herausforderungen in der sich wandelnden Arbeitswelt

Kathrin Kromark (Berufsgenossenschaft für Gesundheitsdienst und Wohlfahrtspflege) und Dr. Annekatrin Wetzstein (IAG) thematisierten die Herausforderungen von Multikausalität und Multifinalität in der Evaluation von komplexen Interventionen. Grenzen beim Forschungsdesign von Evaluationsvorhaben ergeben sich oftmals dadurch, dass der „Königsweg“ des (quasi-)experimentellen Designs mit mehreren Messzeitpunkten und der Untersuchung einer Kontroll- oder Wartegruppe in der Praxis nicht umsetzbar ist. Um diesen methodischen Herausforderungen zu begegnen, schlagen die ReferentInnen Folgendes vor: die Methodenvielfalt nutzen, kreative Herangehensweisen wählen und qualitative Methoden (Workshops, Gruppendiskussionen, Fokusgruppen etc.) einsetzen.

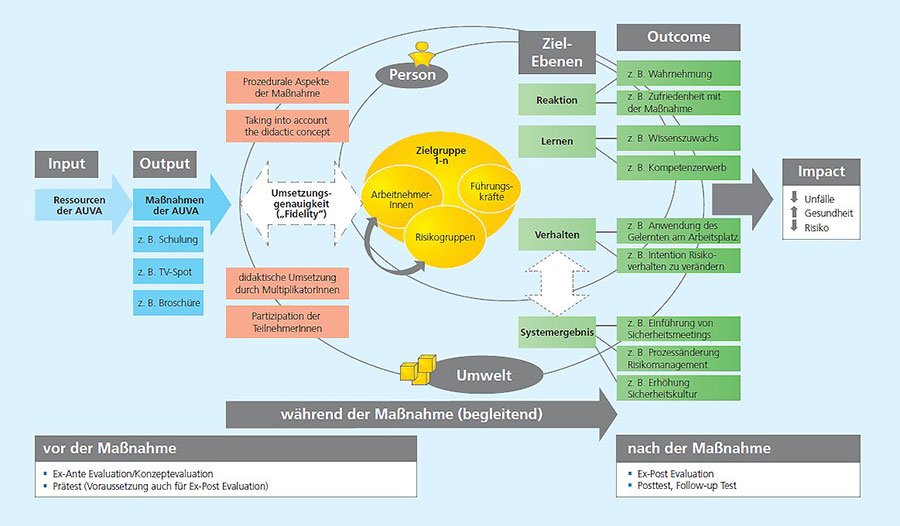

Darüber hinaus empfehlen sie die Entwicklung eines Wirkungsmodells bereits bei der Konzeption der Maßnahme unter Beobachtung der Kontextfaktoren. Das Wirkungsmodell ist für Kromark und Wetzstein zentral für das Verstehen und Analysieren von Erfolgen und Misserfolgen und sollte grafisch festgehalten werden. Wirkungsmodelle machen komplexe Zusammenhänge übersichtlich, bilden die Kommunikationsgrundlage für alle am Projekt und an der Evaluation Beteiligten und stellen den zeitlichen Wirkungsverlauf dar. Beim Entwickeln des Evaluationskonzepts sollte überlegt werden, ob in bestimmten Situationen bewusst auf eine Wirkungsevaluation zugunsten einer Konzept- und Prozessevaluation verzichtet werden sollte. Für Kromark und Wetzstein ist es wichtig, für Veränderungen des Evaluationskonzepts im Projektverlauf offen zu sein und konstruktiv mit unvorhersehbaren Entwicklungen umzugehen. Dies stelle einen wichtigen Beitrag zur Fehlerkultur und keine empirische „Verfehlung“ dar.

Qualitative Methoden als Chance?

Neben einer Posterpräsentation zur Evaluation der Kampagne „Hände gut, alles gut“ (Herbst 2014 bis Ende 2015) hatten die Referentinnen und Referenten der AUVA die Möglichkeit, in einem Vortrag die Herangehensweisen der AUVA in der Evaluation von komplexen Projekten und Kampagnen insbesondere unter Einsatz von qualitativen Methoden vorzustellen. Dabei wurden die beiden für die Evaluation in der Prävention der AUVA wichtigen Publikationen „Integratives Baukastensystem für Evaluationen im Präventionsbereich der AUVA – IBE“ (Spiel et al. 2013) sowie „Qualitative Erhebungs- und Auswertungsmethoden zur Umsetzung qualitativ hochwertiger Evaluationen“ (Flecker et al. 2016) präsentiert. Mit dem „Integrativen Baukastensystem“ entwickelte die AUVA 2013 einen Standard für die Evaluation im Bereich Prävention, um der Bewertung von Interventionen einen vergleichbaren Rahmen zu geben (vgl. Spiel et al. 2013). Das IBE besteht aus verschiedenen Bausteinen, die unterschiedliche Ansätze von und Blickwinkel auf Evaluation in ein Modell zusammenfügen und die DeGEval-Standards für Evaluationen berücksichtigen.

Die einzelnen Bausteine des Modells sind entlang des Ablaufs von Präventionsprojekten (Start, Entwicklung, Einschulung, Intervention, Abschluss) dargestellt. Der letzte Schritt des Baukastensystems beschäftigt sich damit, dass es auch andere Gründe für ausbleibende Effekte als die mangelnde Wirksamkeit der Maßnahme selbst geben kann.

Der ausbleibende Effekt kann auch daran liegen, dass das Programm oder die Maßnahme nicht so umgesetzt wurde, wie es eigentlich geplant und vorgesehen war (Fidelity oder Umsetzungsgenauigkeit). Besonders wichtig ist dieser Faktor, wenn ein Projekt von einer Projektgruppe vorbereitet wird und von MultiplikatorInnen (z. B. BeraterInnen in der Praxis) durchgeführt werden soll.

Eine allgemeine Herausforderung in der Evaluation von Präventionsleistungen stellt neben dem adäquaten Umgang mit der Komplexität der Präventionsthematik auch der angemessene Einsatz von qualitativen Methoden in der Evaluation dar. Insbesondere bei der Frage nach dem „Warum und Wieso“ der Wirkung von Präventionsmaßnahmen greifen standardisierte Methoden der Informationsbeschaffung oft zu kurz. Quantitative Erhebungsinstrumente (z. B. Fragebogen, Beobachtungsbogen) können die soziale Wirklichkeit in ihrer Vielfalt nur eingeschränkt und ausschnittsweise erfassen (vgl. Lamnek 1995).

„Die vollständige Erfassung komplexer Wirkungsgefüge mit ausschließlich standardisierten Instrumentarien, d. h. die Erfassung aller wirksamen unabhängigen Variablen, ist nicht möglich. Es bedarf jeweils auch qualitativer Verfahren, um solche im Vorwissen und bei der Konzeption der Evaluation nicht präsenten Sachverhalte überhaupt entdecken zu können“ (Kuckartz et al. 2008, S. 14). Die Evaluationsforschung bedient sich häufig einer Mischung quantitativer und qualitativer Methoden (vgl. Bortz und Döring 2006). Erstere sind geeignet, Häufigkeiten und Verteilungen darzustellen sowie Wirkungs- und Ursachenzusammenhänge herzustellen. Qualitative Evaluation ermöglicht dagegen das Erfassen von komplexen Einstellungs- und Handlungsmustern von Einzelpersonen und Gruppen sowie von Prozessen und Dynamiken sozialer Systeme.

Im Rahmen qualitativer Erhebungsverfahren können Menschen ihre subjektiven Sichtweisen und Meinungen in ihrer eigenen Sprache entwickeln. Es gilt, die Werthaltungen derjenigen zu rekonstruieren, die Gegenstand der Evaluation sind, und diese in eine systematische Ordnung zu bringen. Gleichzeitig müssen die EvaluationsforscherInnen ihre eigenen Wertorientierungen reflektieren, um sie nicht unkontrolliert in die Evaluation einfließen zu lassen (vgl. Bohnsack und Nentwig-Gesemann 2010). Dieser theoretische Anspruch wird in der Praxis nicht immer eingelöst: Qualitative Methoden werden vielfach zum Lückenbüßer in einem unzulänglichen quantitativen Design, sie werden zum Synonym für alles, was nicht quantitativ ist, ohne die spezielle Logik und die Grundprinzipien qualitativer Forschung zu berücksichtigen. Wissenschaftliche Ansprüche werden nicht eingehalten und letztlich trifft der Vorwurf der Beliebigkeit die qualitative Forschung insgesamt, obwohl das Problem in ihrer achtlosen Anwendung liegt.

Um die Möglichkeiten der qualitativen Evaluationsforschung gewinnbringend zu nutzen und gleichzeitig eine qualitätsvolle Durchführung sicherzustellen, hat die AUVA das Institut für Soziologie an der Universität Wien beauftragt, Qualitätskriterien für die Anwendung unterschiedlicher qualitativer Erhebungs- und Auswertungsmethoden für die Evaluationspraxis zu beschreiben. Die Ergebnisse sind im AUVA-Report 72 veröffentlicht und sollen als Entscheidungsgrundlage für die Anwendung qualitativer Evaluationsstrategien und -methoden dienen. Zudem unterstützen sie bei der Durchführung qualitativer Evaluationsforschung bzw. bei der Beurteilung der sach- und fachgerechten Anwendung qualitativer Methoden (vgl. Flecker et al. 2016).

Literatur:

- Bortz, J. & N. Döring (2006): Forschungsmethoden und Evaluation für Human- und Sozialwissenschaftler. Berlin Heidelberg: Springer Verlag.

- Bohnsack, R. & I. Nentwig-Gesemann (Hrsg.) (2010): Dokumentarische Evaluationsforschung. Theoretische Grundlagen und Beispiele aus der Praxis. Opladen & Farmington Hills: Verlag Barbara Budrich.

- Dörner, D., Kreuzig, H. W., Reither, F. & T. Stäudel (Hrsg.) (1983): Lohhausen. Vom Umgang mit Unbestimmtheit und Komplexität. Bern: Huber.

- Dörner, D. (1989): Die Logik des Misslingens. Reinbek b. H.: Rowohlt.

- Funke, J. (2006): Komplexes Problemlösen. In: J. Funke (Hrsg.): Denken und Problemlösen, S. 375–445. Göttingen: Hogrefe.

- Flecker, J., Krajic, K., Reiter, C. & E. Wimmer (2016): Qualitative Erhebungs- und Auswertungsmethoden zur Umsetzung qualitativ hochwertiger Evaluationen. Ein Beitrag zum Baukastensystem für Evaluationen im Präventionsbereich der AUVA. Report Nr. 72, AUVA.

- Jelenko M. & T. Strobach: Evaluation komplexer Projekte – Qualitative Methoden als Chance? Vortrag am 5. Fachgespräch Evaluation am 20. April 2018.

- Jelenko, M. & Strobach, T: Darstellung des integrativen Baukastensystems für Evaluationen im Präventionsbereich der AUVA. Posterpräsentation zur Evaluierung der Kampagne „Hände gut, alles gut“ am 5. Fachgespräch Evaluation am 20. April 2018.

- Kromark, K. & A. Wetzstein: Herausforderungen bei der Evaluation komplexer Interventionen in der sich wandelnden Arbeitswelt. Vortrag am 5. Fachgespräch Evaluation am 19. April 2018.

- Kromrey, H. (2001): Evaluation – ein vielschichtiges Konzept. Begriff und Methodik von Evaluierung und Evaluationsforschung. Empfehlungen für die Praxis. In: Sozialwissenschaften und Berufspraxis, 24. Jg., Heft 2/2001.

- Kuckartz, U., Dresing, T., Rädiker, S. & C. Stefer (2008): Qualitative Evaluation. Der Einstieg in die Praxis. 2. Auflage. Wiesbaden: VS Verlag für Sozialwissenschaften.

- Lamnek, S. (1995): Qualitative Sozialforschung. Band 1: Methodologie. 3. Korrigierte Auflage. Weinheim: Beltz, Psychologie Verlags-Union.

- Spiel, G., Finsterwald, M., Popper, V. & N. Hesse (2013): Darstellung des integrativen Baukastensystems für Evaluationen im Präventionsbereich der AUVA. Report Nr. 63, AUVA.

- Von der Weth, R.: Komplexität und Wirkung. Handeln in komplexen Kontexten. Vortrag am 5. Fachgespräch Evaluation am 19. April 2018.

Zusammenfassung

Das 5. Fachgespräch Evaluation bot die seltene Möglichkeit, sich offen zu den Herausforderungen von Komplexität in der Prävention auszutauschen. Wenngleich keine einfachen und schnellen Rezepte für den Umgang mit Vielfalt, Vernetztheit, Dynamik und Intransparenz in der Evaluation existieren, wurden viele Ideen und Herangehensweisen in Form von praktischen Beispielen präsentiert, die in die Präventions- und Evaluationspraxis der Teilnehmenden einfließen können.